Resumo do terceiro dia de conferência: uma sessão pela manhã, quatro na parte da tarde e eu descobri que estou ficando mÃope :-)

Storytelling with FIT – Steve Freeman e Mike Hill

Depois da

sessão de ontem com o Ward Cunningham sobre a importância dos testes para a evolução de um sistema, decidi assistir uma palestra

sobre o framework que ele inventou para testes de aceitação:

FIT. O ponto principal

da palestra foi mostrar a importância dos testes de aceitação como meio de comunicar requisitos. Eu já ouvi muitas

conversas por aqui sobre a utilização da palavra “teste”, pois muitos podem achar que o único objetivo de um teste

é encontrar erros (e sabemos que, apesar de eficientes, testes não provam a ausência de bugs). Ao invés de “teste”,

os apresentadores tentaram usar o termo “documento”, pois os testes de aceitação no FIT são páginas HTML contendo

texto e tabelas com exemplos que especificam o comportamento esperado do sistema. O mais interessante é que o

documento é algo executável. Com isso você tem como especificar os critérios de aceitação de uma história antes de

ter a implementação pronta (a idéia de escrever testes antes do código aplicada num contexto mais amplo).

Ao implementar a funcionalidade esperada, você utiliza ferramentas como os testes de unidade e

TDD para garantir

a qualidade do código. Porém o desenvolvedor é também responsável por fazer o teste de aceitação passar. Para isso,

você precisa escrever um

Fixture, que na verdade é uma classe

que será chamada pelo framework e te dará acesso aos dados escritos no documento FIT. A partir daÃ, você faz as

chamadas necessárias ao código da sua aplicação e avalia os resultados de acordo com as expectativas descritas no

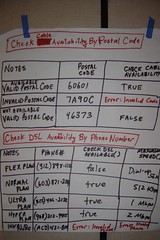

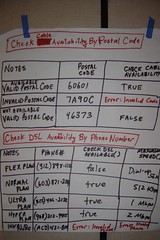

documento FIT. Abaixo são duas tabelas que fizemos para especificar uma parte de um sistema de venda online de

serviços de internet:

Agile Quality: A Canary in a Coal Mine – Ken Schwaber

A sessão que escolhi participar depois do almoço foi do outro inventor do

Scrum:

Ken Schwaber. Ele falou sobre a importância da qualidade como

atributo essencial num sistema de software: devemos nos preocupar com a qualidade desde o inÃcio. O custo para

colocar a qualidade depois é muito alto, podendo até levar um projeto ao fracasso no longo prazo devido à perda

de vantagem competitiva. Quando mais tempo você gasta lidando com defeitos no seu sistema, menos tempo sobre para

pensar no valor que ele está trazendo para o negócio. E o principal objetivo de qualquer sistema de software

deve ser agregar valor ao negócio. Na sua palestra, Ken tentou mostrar a importância da qualidade para um projeto de software e defendeu a idéia de que cortar qualidade deve ser uma

decisão de negócio.

Agile Stories – Research Papers

Na segunda metade da tarde, resolvi assistir à apresentação de 3 papers, numa trilha chamada “Agile Stories”.

Falarei um pouco sobre cada um dos papers nos tópicos abaixo:

The Deployment Production Line – Jez Humble, Chris Read e Dan North

Esse artigo foi bem interessante: eles mostraram uma forma efetiva de estruturar e automatizar a implantação da sua

aplicação em diferentes ambientes (teste, integração, aceitação, …). O artigo explica de forma mais detalhada a idéia

da linha de produção que eles desenvolveram num projeto da

ThoughtWorks. O interessante

é que eles automatizaram o processo de tal forma que qualquer pessoa podia fazer o deploy de qualquer versão do sistema

em qualquer ambiente com poucos cliques. É interessante ressaltar também o modo em que eles quebraram as dependências

para acelerar a execução dos testes nos diferentes ambientes, paralelizando em várias instâncias separadas do

Cruise Control a execução dos testes de unidade, testes de aceitação nos

cenários de sucesso (

smoke tests, que rodam mais rápido), testes de aceitação nos cenários mais complicados (demoram

mais), testes de performance, etc. Com isso, um determinado

build vai ganhando “medalhas” conforme passa em

cada etapa de teste, ficando fácil de saber quando ele pode ou não ser implantado em ambiente de produção.

The Cost of Code Quality – Yuri Kharmov

Essa apresentação foi, por enquanto, a pior da conferência. Foi o oposto da palestra do Ken Schwaber

que eu tinha acabado de assistir. O autor defendeu a idéia de que nem sempre precisamos

nos preocupar com a qualidade quando escrevemos código. O principal argumento dele é: toda preocupação com

qualidade tem um custo associado e você deve considerá-lo na hora de usar técnicas como TDD ou Integração ContÃnua,

em outras palavras, não é um grande problema ter um sistema cheio de bugs se eles não te atrapalham.

Duas coisas me incomodaram: em primeiro lugar ele transpareceu não entender a verdadeira essência de

TDD como uma

ferramenta que possibilita o

Design Incremental.

Segundo, quando perguntaram para ele ao final da palestra quantas vezes ele discutia sobre qualidade de código com

o cliente, ele respondeu “Quase nunca”. Como ele pode julgar pelo cliente o valor da ausência ou não de bugs se ele

nunca discute sobre isso?

Appropriate Agile Measurement: Using Metrics and Diagnostics to Deliver Business Value – Deborah Hartmann e Robin Dymond

A última palestra do dia foi sobre métricas ágeis. Eu achei bem interessante a distinção entre “Diagnósticos” e “Métricas”

proposta pelos autores:

- “Diagnósticos”: são números que te ajudam a entender o andamento das coisas em relação ao processo. Por exemplo: medir a velocidade do time; interpretar o gráfico de “Burn-Down” para descobrir se o time irá terminar no prazo; ou saber a quantidade de defeitos. “Diagnósticos” dependem do contexto do time e devem ser temporários, ou seja, descarte-os assim que o processo estiver funcionando.

- “Métricas”: são números que medem o valor de negócio que seu sistema está produzindo. Por exemplo: retorno de investimento; lucro; ou presença de mercado. “Métricas” são mais difÃceis de medir, por isso é bom escolher apenas uma.

É preciso tomar cuidado com as métricas que você escolhe para avaliar o desempenho de uma equipe ágil, afinal

“You get what you measure”. Outra coisa que eles mostraram foi um template para ser utilizado na hora de

criar uma métrica ágil, com pontos que te fazem pensar sobre o verdadeiro valor que aquela métrica irá representar

quando estiver medindo o sucesso do seu software.

Twitter

Twitter LinkedIn

LinkedIn Facebook

Facebook Flickr

Flickr